Фраза дня:

Гол как сокол [а остер как топор].

it-gravity.co

Система поиска необходима при нахождении какой-либо информации в сети. Любая поисковая система действует совместно с поисковым роботом. Он занимается поиском новой информации об интернет-страницах, а также об их обновлениях. Поисковый робот можно охарактеризовать как автоматическую программу. Эту программу можно сравнить с браузером. То есть робот проверяет данные с интернет-страниц.

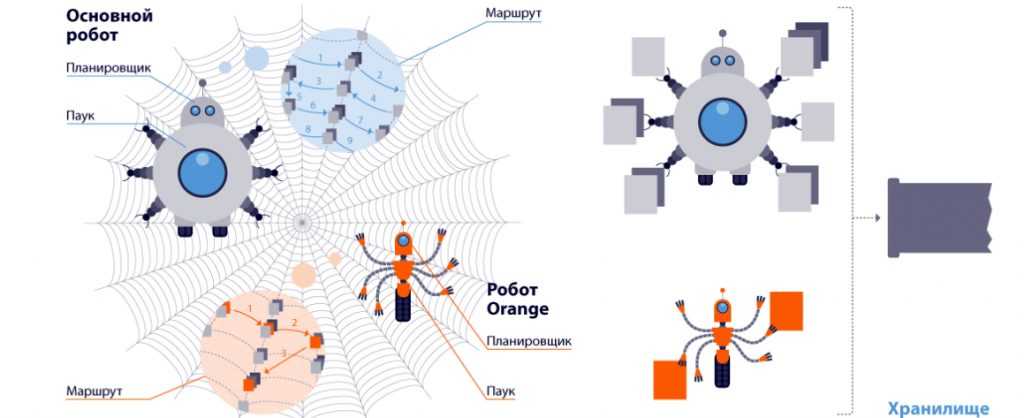

Синонимами поискового робота являются бот, поисковый паук, краулер, web spider, web crawler, ant, bot, automatic indexer,web robots. С этими понятиями можно столкнуться в русскоязычном или англоязычном интернете. В поисковой системе возможно несколько поисковых ботов. И отдельный поисковый робот имеет свою программу, которая выполняет составленный алгоритм поиска. Каждый отдельный бот выполняет конкретные задачи для разных сайтов.

Разберем работу поискового робота. Если вообразить большой океан, который усыпан множеством островов, то робот-искатель будет кораблем. Некоторые острова уже открыты, исследованы и внесены на карту, другие новые острова еще не исследованы. Некоторые острова еще только появились, например, в ходе какого-нибудь природного явления. И вот у корабля-исследователя появляется задача посетить острова, собрать как можно больше данных и внести на карту найденную информацию.

Таким образом, на карте мира появляются новые острова. Острова застраиваются, другие острова пустуют. Некоторые исчезают, проваливаясь под воду. Принцип занесения новых островов на карту подобен действию поисковых ботов. Поисковой паук находит новые сайты во всемирной «интернет-паутине», сканирует страницы, файлы, проверяет информацию о них, и записывает в общий перечень. Следственно все свежие материалы будут просканированы поисковым роботом.

Благодаря поисковому боту поисковая система теперь может на запрос выдать более верный результат, так как бот уже просканировал последние сведения и внес их в индекс. Сайты также не обойдутся без поискового паука. Ведь поисковая система благодаря боту выдает по запросу тот сайт, с которым связан вопрос. В результате пользователь получает корректный релевантный результат на свой запрос.

Если представить, что в мировой паутине возник новый остров, то как долго веб-паук будет до него добираться? Какое время потребуется на исследование новой информации? Сколько времени займет помещение новых данных в реестр поисковой машины? Все ли данные будут видны пауку? Все ли изменения на сайтах будут исследованы? И как сделать так, чтобы поисковая система не выдавала в ответе некоторые страницы или файлы.

Паук работает так, что новый сайт все равно будет обнаружен и проиндексирован. Но весь этот процесс может длиться месяцами. Чтобы этого не произошло, нужно занести его в специально предназначенные инструменты веб-мастеров при поисковых системах (Google, Яндекс). Поисковые пауки этих известных систем могут отличаться друг от друга.

Если робот исследовал один раз сайт, то он будет регулярно это делать. Но такая регулярность связана с изменениями на сайте. Если обновления происходят раз в день, то бот будет появляться также раз в день. Имеются блоги, где информация обновляется несколько раз в день. Целесообразно поисковой робот будет контролировать изменения часто. У робота есть определенный алгоритм действия, который легко меняется.

Как выше уже было оговорено, в системе есть много различных роботов. У каждого из них поставлены свои задания: этот робот ищет созданные страницы, этот находит «безжизненные сайты» и производит очищение поисковой информации, другой бот сканирует картинки или видео. Также существует поисковый бот, который проверяет правильность ссылок. Бывают боты, которые отслеживают появление новых комментариев и занесение их в перечень. Принцип действия всех поисковых ботов почти одинаков.

Сначала web-робот всегда ищет на интернет-странице установленный файл. Этим файлом является robots.txt. Следующие шаги робота зависят от информации, которую предоставит ему установленный файл. Поисковый робот не справится со своими обязанностями без этого файла. Ведь этот файл как руководство к действию для него.

Robots.txt присутствует на управляемом сервере. Этот руководящий файл может запрещать боту сканировать сайт и тот не будет проиндексирован. Также robots.txt может перекрыть путь к некоторым страницам или файлам. Основная его задача – подсказать пауку, какие разделы сайта можно сканировать и индексировать, а какие нет.